Python 3中的Urllib库的使用

在Python中有着这样一个常用的、基础的爬虫库。在Python2中为urllib.urllib,在Python3中官方为了便于管理,将和请求有关的函数封装进了urllib.request模块中。

在此处,使用Python3做记录。

urlopen函数

urlopen函数是request中的一个很常用的函数,它主要用于打开一个网页。其中有着很多的属性。

1 | from urllib import request |

urlretrieve函数

urlretrieve函数可以很方便的将网页保存至本地。其实用方法见下方代码:

1 | from urllib import request |

urlencode函数

将字典类型的数据转化为url编码的数据

1 | from urllib import parse, request |

parse_qs函数

将url编码后的参数还原为字典形式,其中的值以列表形式进行存储。

1 | from urllib import parse |

urlparse和urlsplit函数

对URL各部分进行分割,其中在使用urlsplit函数时,没有_params_参数。(注:params参数指的是在以下链接中”?”前添加”;”,位于这两者之间的内容,如:_https://www.baidu.com/s;hello?wd=hello+world_)

1 | from urllib import parse |

request.Request类

在爬虫中,如果想使用一些参数,如:请求头,请求数据等,需要使用到Request类。如果只是使用urlopen函数,没有办法进行添加请求头。在没有使用_User-Agent_的时候,如果服务器发现是爬虫,服务器可能会返回一条假的数据内容,或者是不返回内容。所以,将爬虫程序伪装成正常的浏览器访问是很有必要的一件事。

1 | from urllib import request, parse |

注: 可以去挑战一下网络爬虫界的“珠穆朗玛峰” —– 拉勾网

ProxyHandler处理器

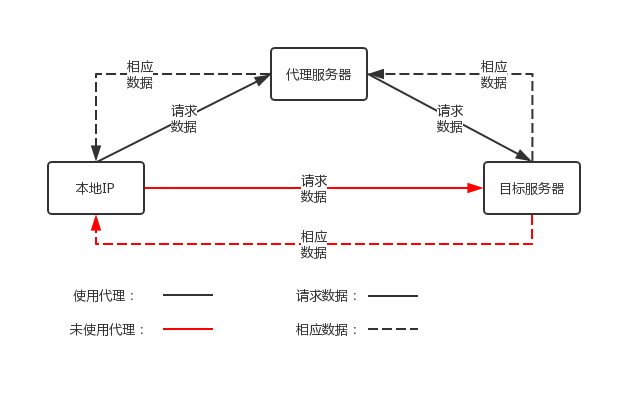

在爬取网站时,一般情况下网站都会做一些反爬虫机制,如封ip。如果只使用一个ip地址进行爬取,在网站封掉ip地址后,就无法获取数据了。所以,在有反爬虫机制的情况,反反爬虫机制便可以使用了。在urllib中通过使用ProxyHandler进行设置代理服务器。

在使用代理与未使用代理的区别:

1 | from urllib import request |

常用的代理:

Cookie是什么

在网站汇总,http请求是无状态的。在第一次和服务器建立连接登录后,第二次请求服务器依旧不能知道当前请求的用户是谁。Cookie的出现就是为了解决该问题。第一次登录后,服务器会返回一些数据(cookie) 给浏览器,然后浏览器将数据保存在本地。当用户发送第二次请求时,浏览器会自动的将保存在本地的数据(cookie)一起发送给服务器。服务通过判断不同的cookie信息,进行确认用户。cookie的存储大小是有限的一般不会超过4KB,因此在设置cookie对的时候,只能存储少量数据。

cookie的格式:

Set-Cookie: NAME=VALUE;Expires=DATE;Path=PATH;Domain=DOMAIN_NAME;SECURE

参数含义:

- NAME:Cookie的名字

- VALUE:Cookie的值

- Expires: Cookie的过期时间

- Path:Cookie作用的路径

- Domain: Cookie作用的域名

- SECURE:是否只在HTTP协议下起作用

使用cookielib库和HTTPCookieProcessor模块模拟登陆

在Python中使用cookie,一般是通过http.cookiejar模块和urllib模块的HTTPCookieProcessor处理器一起使用的。

- http.cookiejar:提供用于存储cookie的对象

- HTTPCookieProcessor:处理cookie对象并构建handler对象

http.cookiejar模块

在该模块中主要有三个类,CookieJar、FileCookieJar、MozillaCookieJar、LWPCookieJar。其作用如下:

- CookieJar:管理HTTP cookie值、存储HTTP请求生成的cookie,向传出的HTTP请求添加cookie对象。整个cookie都存储在内存中,对CookieJar实例进行垃圾回收后cookie失效。

- FileCookieJar (filename, delayload=None, policy=None):从CookieJar派生而来,用来创建FileCookieJar实例。检索cookie信息并将cookie存储到文件中。filename是存储cookie的文件名,delayload为True是支持延迟访问文件,即只有在需要时才读取文件或将数据存储在文件中。

- MozillaCookieJar (filename, delayload=None, policy=None):从FileCookieJar派生而来,创建与Mozilla浏览器cookies.txt兼容的FileCookieJar实例。

- LWPCookieJar (filename, delayload=None, policy=None):从FileCookieJar派生而来,创建与libwww·per标准的Set-Cookies3文件格式兼容的FileCookieJar实例。

保存Cookie至本地

保存cookie到本地,可以使用cookiejar的save方法。

1 | from urllib import request |

加载本地cookie

从本地文件读取cookie信息,可以使用cookiejar中的load方法

1 | from http.cookiejar import MozillaCookieJar |